DeepFakes y desinformación: el reto de detectar audios ‘falsos’ en un proceso electoral

¿Qué tienen en común el cantante Bad Bunny, la activista Gretta Thunberg y el presidente de Rusia Vladimir Putin? Todas escucharon su propia voz en una grabación que nunca hicieron, resultado de una clonación con Inteligencia Artificial (IA).

Eso fue lo que argumentó Martí Batres, jefe de Gobierno de la Ciudad de México, luego de que se le atribuyó un audio en el que supuestamente se dieron instrucciones para manipular el proceso interno de Morena, para definir la candidatura del partido guinda en la capital del país. “Está producido con inteligencia artificial. No es real”, dijo Batres.

En ese caso no se pudo determinar con certeza si el audio fue efectivamente creado con IA. Herramientas como AI Voice Detector no dieron un resultado concluyente, pues al analizar diferentes fragmentos del mismo audio el porcentaje de probabilidad de que fuera hecho con IA variaba desde un 26% hasta casi un 70%.

Para probar la herramienta grabamos un breve audio con nuestra voz natural. Nosotras estábamos seguras de su autenticidad, pero para la herramienta había un 55% de probabilidad de que fuera hecho con IA.

Pese a la evolución de las tecnologías de detección “siempre va a haber un componente de tasa de error”, advierte Manel Terraza, quien es CEO y fundador de loccus, una startup dedicada a la detección de voces sintéticas.

Algunos especialistas en audio señalaban que aspectos como la pronunciación, la entonación y las pausas para respirar eran muestra de que el audio que se atribuyó a Batres no fue hecho con IA; pero para otras personas esos mismos elementos eran prueba de que el audio fue creado con tecnología y no pronunciado por el jefe de gobierno.

De hecho, las autoridades de la Ciudad de México dedicaron varios minutos de una conferencia de prensa para demostrar lo sencillo que es recrear un audio con tecnología por menos de “200 pesos al mes”. Este mismo ejercicio fue replicado por usuarios de X, antes Twitter, que una y otra vez crearon audios donde una voz similar a la de Batres confiesa cosas, en algunos ejemplo con acento extranjero.

Pese a ello, su difusión en redes sociales volcó la conversación en torno a la posible división dentro del mismo partido, todo ello días antes de que concluyera este proceso preelectoral.

El audio de Batres también hizo evidente que el mal uso de la inteligencia artificial en procesos electorales puede dar lugar a la desinformación y la manipulación del discurso público. Algo que en otros países como Venezuela, Colombia y Estados Unidos ya han experimentado en sus más recientes elecciones.

En este sentido, verificadores como Cazadores de FakeNews en Venezuela o Colombia Check ya han descrito que determinar si un audio es real o falso no es tan sencillo y requiere de la combinación de elementos tecnológicos, pero sobre todo de la observación del contexto en el que se comparte.

Es decir, además de emplear análisis con herramientas de detección, buscar detalles en el sonido y pedir el apoyo de especialistas en la materia; además, es necesario identificar qué narrativa reproduce, quién comenzó la difusión del material y a quién beneficia que se haga viral.

¿Qué es la inteligencia artificial?

La inteligencia artificial o IA puede definirse como un área de la informática “que lo que busca es crear sistemas que puedan realizar actividades que generalmente solo eran atribuidas a los humanos, pero que ahora se pueden hacer a través de estos sistemas”, según nos dijo Paul Aguilar coordinador de seguridad digital en socialTIC, una organización sin fines de lucro que se dedicada a la investigación y formación de la tecnología digital para fines sociales.

Existen diferentes tipos de IA, pero la que se utiliza para crear contenido como fotos, imágenes, texto o audio es la inteligencia artificial generativa. Esta tecnología permite crear este tipo de contenido con modelos que le permiten aprender o copiar un conjunto de datos de un contenido creado por personas. Es decir, la IA copia o imita algo que un ser humano ya había hecho. Hablar, por ejemplo.

Los audios deepfakes son precisamente audios muy similares o idénticos a la voz de una persona y que se pueden generar porque se entrenó un sistema de inteligencia artificial para clonar o aprender la voz de una persona.

Entonces, en palabras de Paul Aguilar, cuando hablamos de inteligencia artificial y de audios deepfakes nos referimos a “sistemas que aprenden a imitar la voz de una persona para poder generar audios a partir de de esta imitación”.

¿Cómo se hace un audio falso?

Lo primero que tenemos que saber es que se puede usar IA para crear audios desde cero, o para modificar audios reales, según explicó a El Sabueso Manel Terraza.

Él explica que para clonar una voz, sin consentimiento, basta con tomar muestras de audios de la persona y pasarlos por un software capaz de imitar la voz y decir lo que se le pida.

“Este es el problema principal de riesgo en el mundo de la desinformación porque cualquiera puede ir y tomar el audio de un video de un político y hacer un clon de una voz”, advierte Terraza, quien agrega que existen modelos de IA con los que se puede hacer pasar la voz de una persona como si fuera de otra en tiempo real. Es decir, puede clonarse una voz mientras se sostiene una conversación.

Tal y como le sucedió en 2019 al director de una empresa de energía en Reino Unido. El ejecutivo recibió una llamada de quien pensó era un directivo de la misma compañía que le pidió transferir 243 mil dólares, se hizo la transferencia según lo indicado pero resultó ser un plan para estafar a la empresa mediante el uso de IA.

De hecho, Terraza señala que hoy en día hay muchas herramientas para clonar voz sin necesidad de tener ningún tipo de habilidad técnica. “Tan fácil como entramos en Facebook. Y esa facilidad es el punto principal por el cual existe un riesgo tan grande de que se use de forma fraudulenta”, señala.

O tan sencillo como navegar por TikTok, donde creadores de contenido muestran una y otra vez cómo crear audios con Inteligencia artificial y hasta un paso a paso de cómo el creador de FlowGPT clona las voces de los artistas como Bad Bunny para crear álbumes completos con Inteligencia Artificial.

Nosotros, por ejemplo, encontramos una app que invita a los usuarios a crear audios para imitar a sus personajes favoritos por tarifas desde 120 pesos (7 dólares) al mes. En algunos de esos modelos se puede solicitar que la voz reproduzca una emoción como felicidad o enojo, e incluso se cuenta con todo un catálogo que va desde caricaturas hasta youtubers.

Eleven Labs por su parte tiene una herramienta para generar audios de cualquier texto que se le indique, usando un enorme catálogo de voces que incluye una “dulce joven británica”, un “hombre autoritario de mediana edad” y una “mujer entusiasta con acento hindú”. Esta tecnología también puede clonar voces y traducirlas.

¿Cómo identificar deepfakes?

Paul Aguilar señala que el nivel de precisión, o de qué tan idénticos o similares son estos audios, va a depender del tipo de tecnología con el que se creó. Por lo que, en algunos casos, todavía se pueden detectar ciertas anomalías dentro de la voz.

Por ejemplo, algunos tonos no corresponden a cómo la persona pronunciaría ciertas palabras, o la congruencia o el nivel de dicción que tiene el audio creado no suena exactamente igual a cómo lo haría la persona real.

“Entonces se puede de alguna manera identificar o llegar a sospecharse que estos audios pudieran ser falsos, pero pues las herramientas están avanzando lo suficientemente rápido como para generar audios más reales o más cercanos a la voz de de una persona”, y por lo tanto más difícil de identificar.

Manel Terraza coincide, pues dice que los modelos más avanzados de síntesis de voz te permiten replicar respiraciones y pausas como las que tiene la persona que queremos imitar. Así que a medida que se van sofisticando las voces sintéticas esas diferencias son menos obvias.

“Al día de hoy prácticamente es imposible diferenciar para una persona una voz sintética buena de una real, y por lo tanto el problema de la detección es cada vez más complejo y requiere también de tecnología”, señala Terraza.

El especialista también explica que las tecnologías de detección lo que hacen es dar una probabilidad de que ese audio sea natural o creado con IA, pero su efectividad también depende de aspectos como el volumen, la duración, y qué tanto ruido ambiental hay. Por lo que siempre habrá posibilidad de que el resultado no sea correcto.

Terraza señala con el perfeccionamiento de este tipo de tecnología de generación de contenido, la única forma de tener una aproximación de si algo es real o es clonado es utilizando herramientas de detección basadas en inteligencia artificial es decir, “luchar con las mismas armas”.

¿Qué herramientas existen para identificar audios?

Existen proyectos como AntiFake, que buscan prevenir la generación de deepfakes usando IA para modificar los audios – sin afectar como lo escuchamos los humanos– y que estos no puedan ser imitados por otras IA.

También nos encontramos con una herramienta gratuita de ElevenLabs que precisamente busca tratar de ayudar a los usuarios a identificar los audios creados con IA, especialmente los que fueron generados con su misma tecnología.

Como ya mencionamos, otra de las herramientas que hemos encontrado es AI Voice Detector, pero es de paga. Al igual que el nuevo desarrollo de Loccus.ia.

Probamos estas últimas tres con un audio generado a partir de un texto con la herramienta de ElevenLabs, una grabación de mi propia voz, y el audio que se le atribuyó a Batres, aunque él lo negó.

Tanto ElevenLabs como Loccus acertaron a determinar que la grabación hecha con mi propia voz era una voz humana. Pero AI Voice Detector se equivocó, y señaló que había 55% de probabilidad de que fuera hecha con IA.

En el caso del audio que creamos con IA, las tres herramientas detectaron que se trataba de un audio fabricado.

En el caso del audio viral que se atribuyó a Batres –del que no tenemos certeza de su origen– ElevenLabs determinó un 98% de probabilidades de que fuera hecho con IA; AI Voice Detector señaló un porcentaje de entre 26 y 70% creado con IA; mientras que Loccus determinó un porcentaje de entre 5% y 25% creado con voz natural. Es decir, más del75% de probabilidad de que fuera hecho con IA.

Entonces las tres herramientas acertaron al detectar la voy creada con IA, solo dos acertaron a identificar un audio con voz natural, y dos de tres coinciden en que el audio viral de Batres fue hecho con IA.

¿Consejos para no caer en desinformación con audios falsos?

Paul Aguilar recomienda identificar el contexto del audio para saber si corresponde a algo que la persona podría o no haber dicho. También recomienda identificar la calidad del sonido o la consistencia vocal.

La tercer recomendación de Aguilar es verificar la fuente de información para saber si quien está publicando o filtrando este audio es confiable, o alguien de quien se podría sospechar que tal vez está generando esta información o falsificándola.

Aguilar dice que hay otras técnicas más especializadas, pero poco accesibles. Pues se requieren de herramientas especializadas para ingeniería de audio en donde se hace un análisis espectral del sonido, por ejemplo.

Ante este panorama, para Terraza hay que poner en duda todo lo que no te estén diciendo cara a cara, sobre todo el contenido especialmente incendiario. Los reenvíos masivos de cosas también te pueden indicar que un audio fue creado para desestabilizar o causar polémica.

¿Existe una legislación para los deepfakes?

César Avilés, investigador del Instituto Belisario Domínguez, nos explicó que “explícitamente no existe una disposición en la legislación electoral que atiende específicamente esta problemática” de la desinformación generada con IA.

Sin embargo, el especialista señala que sí existe una regulación que sanciona las calumnias, el daño a la honorabilidad de las personas, el uso de la violencia política de género, entre otras conductas que podrían entrar en el mal aprovechamiento de esta herramienta tecnológica.

Luego del audio que Martí Matres argumentó fue creado con Inteligencia Artificial, el diputado morenista Miguel Torruco propuso una reforma al código penal para sancionar a quien use IA para generar daño o perjuicio a la imagen o reputación pública de las personas.

Avilés señala que es positivo que a partir de ello se capte la atención de las y los tomadores de decisiones para poner manos en la materia, pero es necesario no perder de vista que se trata de un fenómeno mucho más complejo que necesita una legislación transversal.

“Apenas ahorita a nivel federal el Congreso está poniendo atención en el fenómeno como tal sobre qué implica la inteligencia artificial, una tecnología sumamente disruptiva que apenas estamos conociendo sus aprovechamientos, pero también cuáles son las distorsiones y las problemáticas que podrían afectar los derechos de las personas”, advierte Avilés.

Relacionado

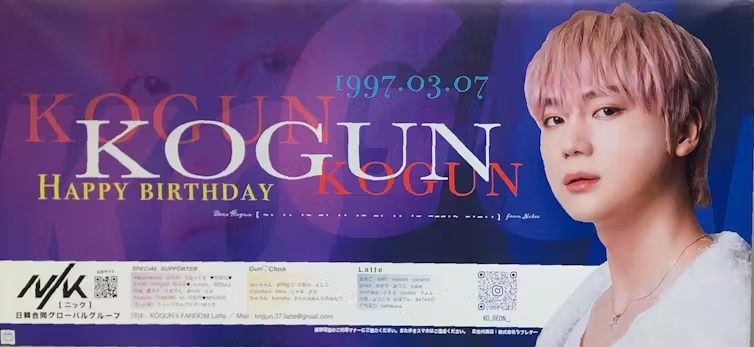

Oshikatsu se refiere a los esfuerzos que hacen los fans para apoyar a su oshi favorito, que puede ser un artista, un personaje de anime o manga, o un grupo que admiran y quieren “impulsar”.

Los carteles en la enorme estación de trenes de Shinjuku, en Tokio, normalmente se usan para publicitar productos como cosméticos y comida, así como películas nuevas.

Pero ocasionalmente uno puede encontrarse con un cartel que muestra un mensaje de cumpleaños y la foto de un joven, a menudo de una boy band y típicamente con una apariencia impecable.

Estos carteles son creados por empresas publicitarias especializadas y son pagados por fans devotos. Forman parte de un fenómeno llamado oshikatsu, un término acuñado en los últimos años que proviene de las palabras japonesas “apoyar” (oshi) y “actividad” (katsu).

Oshikatsu se refiere a los esfuerzos que hacen los fans para apoyar a su oshi favorito, que puede ser un artista, un personaje de anime o manga, o un grupo que admiran y quieren “impulsar”.

Una parte considerable de este apoyo es de naturaleza económica. Los fans asisten a eventos y conciertos, o compran productos como CDs, carteles y otros artículos coleccionables. Otras formas de oshikatsu están destinadas a difundir la fama de su ídolo, compartiendo contenido sobre su oshi, participando en campañas en redes sociales, y escribiendo fanfiction o creando fanart.

Oshikatsu surgió a partir del deseo de los fans por tener un vínculo más cercano con sus ídolos. La combinación entre oshi y katsu apareció por primera vez en las redes sociales en 2016 y se generalizó como un hashtag en la entonces plataforma de Twitter en 2018. En 2021, oshikatsu fue nominada como candidata a la palabra del año en Japón, una señal de que su uso se había vuelto popular.

Ahora, ha aparecido en el radar del Japón empresarial. El motivo es el estallido de la inflación en los últimos años, provocado por la interrupción pandémica de la cadena de suministro y las conmociones geopolíticas, que ha hecho que los consumidores japoneses reduzcan su gasto.

Sin embargo, con los salarios a punto de subir por tercera vez en tres años, el gobierno se muestra cautelosamente optimista ante la posibilidad de que el crecimiento económico sea reavivado a través del gasto impulsado por el consumo. Compañías de la industria del entretenimiento y medios de comunicación buscan en el oshikatsu como posible motor de esta tendencia, aunque no está claro si las próximas subidas salariales serán suficientes.

Un fenómeno ampliamente extendido

Contrario a la percepción popular, oshikatsu ya no es del ámbito exclusivo de las subculturas juveniles. Se ha hecho camino también entre los grupos de mayor edad en Japón.

De acuerdo a una encuesta realizada en 2024 por la empresa japonesa de estudios de mercado, Harumeku, el 46% de las mujeres que están en sus 50 tienen un oshi al que apoyan económicamente. Las generaciones mayores tienden a tener más dinero para gastar, especialmente después de que sus propios hijos hayan terminado su educación.

Oshikatsu también supone una interesante inversión en términos de género. Mientras en los hogares tradicionales japoneses se sigue esperando que los maridos sean el sostén económico de las familias, en el oshikatsu son más a menudo las mujeres las que apoyan económicamente a hombres jóvenes.

Cuánto gastan los fans en sus oshi, depende. Según una encuesta reciente realizada por la empresa japonesa de marketing CDG y Oshicoco, una agencia de publicidad especializada en oshikatsu, la cantidad media que gastan los fans en actividades relacionadas con sus oshis es de 250.000 yenes (unos US$1.736) anuales.

Se calcula que esto aporta cada año 3,5 billones de yenes (US$24.500 millones) a la economía japonesa, y representa el 2,1% del total de las ventas minoristas anuales de Japón.

Oshikatsu impulsará el gasto de los consumidores. Pero dudo que tenga el impacto en la economía japonesa que esperan las autoridades. Para los aficionados más jóvenes, el peligro es que la aprobación gubernamental acabe con cualquier tipo de influencia cool, haciendo que el oshikatsu sea menos atractivo para estas personas a largo plazo.

Y si apoyan a un oshi que aún no ha conseguido el éxito, pueden tener una mayor sensación de que su apoyo importa. De ahí que parte del gasto vaya directamente a individuos, en lugar de a superestrellas corporativas ya establecidas. Pero también es posible que los jóvenes oshis en apuros gasten más de este dinero que las celebridades establecidas.

La prensa internacional se está enfocando ya sea en el lado económico del oshikatsu, o en lo peculiar de los fans “obsesivos” que consiguen un segundo trabajo para apoyar a su oshi, y madres que gastan grandes sumas en un hombre que tiene la mitad de su edad. Pero lo que esa cobertura pasa por alto es la lenta pero profunda transformación social de la que el oshikatsu es un síntoma.

Una investigación de 2022 sobre personas que practican oshikatsu deja claro que las “actividades de fans” responden a un deseo profundo de conexión, validación y pertenencia. Si bien esto podría satisfacerse mediante la amistad o una relación íntima, un número creciente de jóvenes adultos japoneses siente que este tipo de vínculos son “problemáticos”.

Los hombres jóvenes lideran esta tendencia, especialmente aquellos que no trabajan como asalariados de oficina con empleos relativamente estables, los llamados salarymen. Muchos de los que trabajan a tiempo parcial o en empleos manuales tienen dificultades para imaginar un futuro con una familia.

El sector terciario está cambiando para dar cabida a un número creciente de servicios que convierten en productos cosas intangibles como la amistad, la compañía y las fantasías románticas escapistas.

Desde abrazos no sexuales hasta alquilar a un amigo por un día o tener una cita con un acompañante travestido, se puede buscar alivio temporal de la soledad pagando por hora. Como resultado, la conexión humana en sí misma se está convirtiendo en algo que puede ser consumido mediante pago.

Por otro lado, compartir actividades de oshikatsu puede generar nuevas amistades. Reunirse para adorar colectivamente a sus ídolos es una forma poderosa de crear nuevas comunidades. Aún está por verse cómo estos cambios en la manera en que las personas se relacionan moldearán el futuro de la economía y la sociedad japonesa.

*Fabio Gygi es profesor titular de Antropología en la Escuela de Estudios Orientales y Africanos (SOAS) de la Universidad de Londres.

Este artículo fue publicado en The Conversation y reproducido aquí bajo la licencia creative commons. Puedes leer la versión original en inglés aquí.

Haz clic aquí para leer más historias de BBC News Mundo.

Suscríbete aquí a nuestro nuevo newsletter para recibir cada viernes una selección de nuestro mejor contenido de la semana.

Y recuerda que puedes recibir notificaciones en nuestra app. Descarga la última versión y actívalas.

Utilizamos cookies propias y de terceros para personalizar y mejorar el uso y la experiencia de nuestros usuarios en nuestro sitio web.