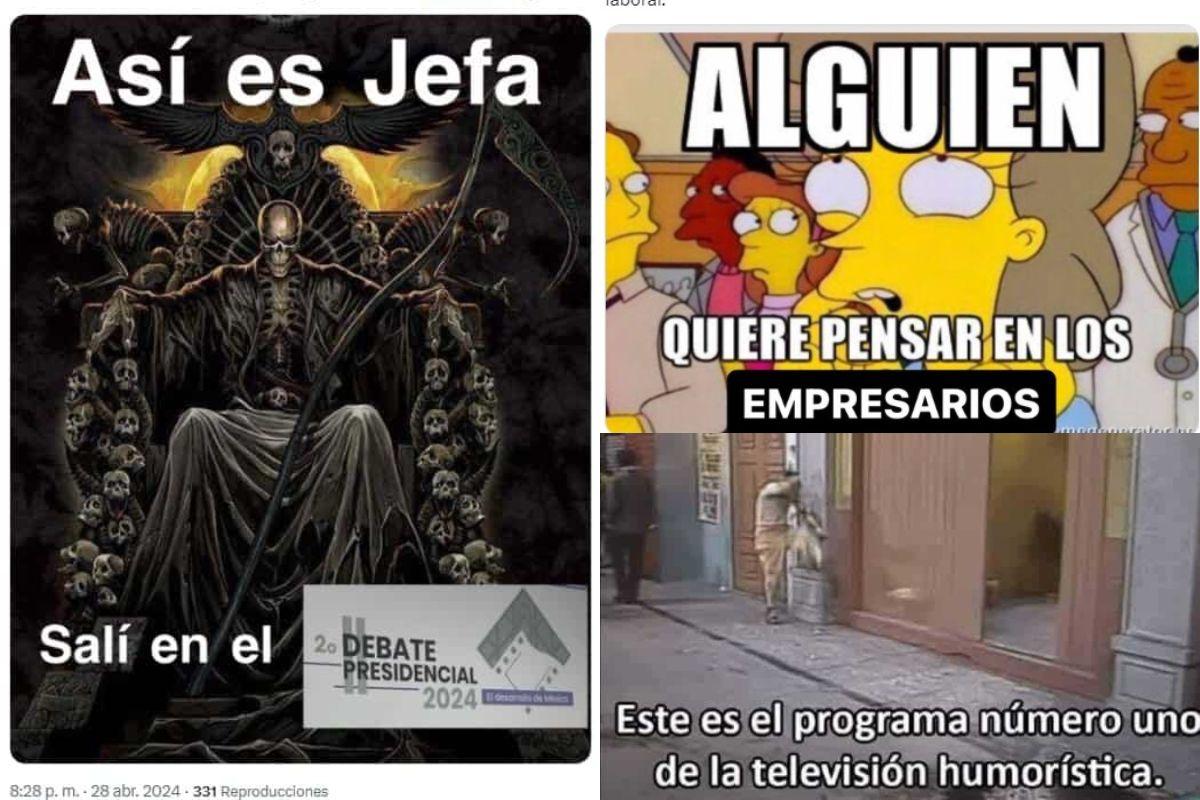

Los mejores memes del segundo debate presidencial 2024

Seguimos con la fiesta de la democracia rumbo a las elecciones presidenciales en México. Nuevamente escucharemos las propuestas de las candidatas y candidato, mientras se sacan sus trapitos al sol. Si te lo perdiste o quieres reírte en lo que pelean, ahí te van los mejores memes del segundo debate presidencial.

Recuerda que tenemos a Xóchitl Gálvez, candidata de la coalición Fuerza y Corazón por México; también a Claudia Sheinbaum, candidata de Morena-PT-PVEM; y que no se nos pase Jorge Álvarez Máynez, candidato de Movimiento Ciudadano.

Si quieres conocer toda la información seria y verificada, visita la sección Elecciones 2024 de Animal Político.

El segundo debate presidencial en memes

¡La gente ya está lista para el debate! Sí, queremos tener fe en que ahora sí hablarán sobre sus propuestas, pero siendo realistas, la gente está preparada para lo que importa: los memes del debate.

Cero dudas y muchas pruebas: el segundo debate presidencial servirá para tener una gran cantidad de memes de calidad y esta nota lo demuestra.

Máynez no se hizo espera para darnos los mejores memes del debate

Máynez no suelta la lengua de señas y ahora empezó recio desde el segundo cero mostrándonos algo nuevo que aprendió.

¡Ay, virgencita! Sí sacaron lo de la Santa Muerte

Pues sí, amix. La playera de Calacas Chidas que ya nos regaló grandes memes (como a Lilly Téllez agarrando su rosario frente a esa imagen) que dice “un verdadero hombre no habla mal de López Obrador” ya hizo su aparición en el segundo debate presidencial y por supuesto que los memes no se hicieron esperar.

También lee: Expertos piden a candidatos presidenciales una nueva agenda ambiental ante crisis climática

Amiga date cuenta: Claudia pasó de “una mujer fría, sin corazón” a “la candidata de las mentiras”.

En el primer debate, Xóchitl Gálvez se empeñó en describir varias veces a Claudia Sheinbaum como una “mujer fría, sin corazón”. Pero en este segundo debate presidencial, no paró de llamarla “la candidata de las mentiras”.

Hasta enseñó un letrero que se volvió gran material de memes que además de decir “Claudia miente” viene acompañado de la frase “Amig@ date cuenta”.

Las cartulinas, grandes protagonistas de memes del segundo debate

Pues no sería un debate presidencial si las candidatas y candidato no llevaran material gráfico para enseñar a cámaras. Pero alguien dígales que o metan menos información, o las hagan más grandes… ¡porque no se ve nada!

Aunque también estas cartulinas son lo que más memes nos dan en los debates. Así que GRACIAS <3.

Mención especial a la cartulina “Deja de mentir”

Grandes memes nos dejó esta cartulina que sacó Xóchitl Gálvez a Claudia Sheinbaum porque la neta nos aplica en todos los días:

“Cuando fui Jefa de Gobierno”…

Y en lugar de darnos propuestas reales (con soluciones igual de realistas), Claudia Sheinbaum se enfocó en decirnos “el gran trabajo” que hizo como Jefa de Gobierno en la CDMX y pos ¡ya basta!

¿Ganaron los memes? Por supuesto

Y sí, nuevamente los ganadores del segundo debate están siendo los memes hasta de las (pocas) propuestas presentadas.

Te puede interesar: ¿Quemar combustóleo a cambio de desarrollo? Hablemos de las zonas de sacrificio ambiental

El otro gran ganador fue ¡Gengar!

¡¿Khé?! Así como lo lees. Durante el segundo debate presidencial se presentaron preguntas en video de varias personas alrededor del país y de ahí salió este gran ganador.

Y es que un chico traía una playera de Gengar (Pokémon) rifadísima que rápidamente se hizo tendencia y también se adueñó de varios memes del debate de este 28 de abril.

¡¿Alguien quiere pensar en los empresarios?!

En el segundo debate presidencial se tocó el tema de la reducción de la jornada laboral y pues la respuesta de Xóchitl Gálvez dejó mucho que desear y un montón de memes.

Y es que la candidata dijo que está a favor de reducirla a 40 horas “siempre y cuando le demos a los empresarios la posibilidad de quitarle tanta carga fiscal… Apoyemos a los empresarios y van a ser los primeros en querer bajar la jornada laboral“.

¡¿Khé?!

El agua de piña

Xóchitl Gálvez se puso ruda en el segundo debate presidencial y cuando se habló sobre el tema del agua sacó una botellita con una muestra tomada de Iztapalapa.

De acuerdo a la candidata —y un estudio que hizo a la muestra— esa agua contiene “heces fecales, orines y contaminantes que provocan cáncer” y retó a Claudia (sin mensionarla directamente) a tomarle un traguito.

Aunque el tema de la calidad del agua es algo muy serio, ya saben que los memes no perdonan y la gente no dejó de pensar en la clásica Coca de piña que podemos ver tirada en las calles de CDMX.

Pa’ponernos serias: Sheinbaum y Gálvez se acusan de “narcogobierno” y contratos ilegales; Máynez se enfoca en propuestas en el segundo debate

No lo dirigió Enrique Segoviano, pero…

Sí, amix. Nueeevamente lo mejor de este segundo debate presidencial fueron los memes con la playera de calaca, “la candidata de las mentiras”, el “cuando fui jefa de gobierno” y la defensa a empresarios este es nuestro México Mágico.

Recuerda que el tercer y último debate presidencial es el próximo domingo 19 de mayo a la misma hora (20:00) y en el mismo canal (YouTube del INE).

Relacionado

Muchas personas que recurren a la IA acaban confundiéndose y tomando por válidas afirmaciones que están alejadas de la realidad.

Cada vez se registran más casos de personas que sufren “psicosis por la IA”, según advirtió Mustafa Suleyman, responsable de inteligencia artificial de Microsoft.

En una serie de publicaciones en la red X, Suleyman escribió que la “IA aparentemente consciente” -las herramientas de IA que dan la apariencia de ser sensibles- le quita el sueño y afirma que tiene un impacto social aunque la tecnología no sea consciente en ninguna definición humana del término.

“Hoy en día no hay ninguna prueba de que la IA sea consciente. Pero si la gente la percibe como consciente, creerá que esa percepción es la realidad”, escribió.

En relación con esto, está surgiendo una nueva afección denominada “psicosis por la IA”: un término no clínico que describe incidentes en los que las personas confían cada vez más en chatbots de IA como ChatGPT, Claude y Grok y luego se convencen de que algo imaginario se ha convertido en real.

Por ejemplo, creer haber desentrañado un aspecto secreto de la herramienta, entablar una relación romántica con ella o llegar a la conclusión de que tienen superpoderes divinos.

Puedes leer: Entre algoritmos y emociones: ¿Puede la inteligencia artificial reemplazar a un terapeuta?

Validación constante

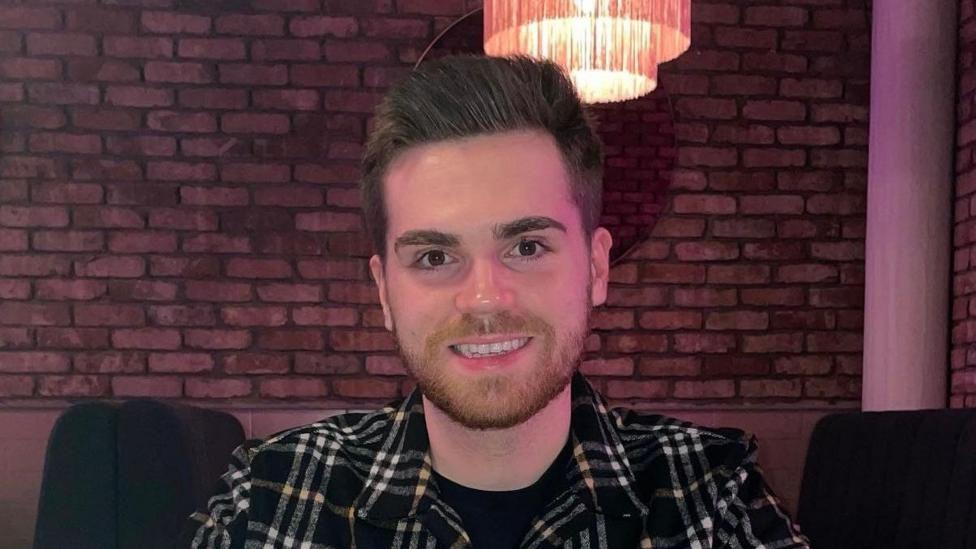

Hugh, originario de Escocia, dice que se convenció de que estaba a punto de convertirse en multimillonario después de recurrir a ChatGPT para que le ayudara a prepararse para lo que consideraba un despido improcedente por parte de un antiguo empleador.

El chatbot empezó aconsejándole que consiguiera referencias de carácter y tomara otras medidas prácticas.

Pero a medida que pasaba el tiempo y Hugh -que no quiso revelar su apellido- daba más información a la IA, ésta empezó a decirle que podría recibir un gran pago y, finalmente, le dijo que su experiencia era tan dramática que un libro y una película sobre ella le reportarían más de US$6millones.

Básicamente, validaba lo que él le decía, que es para lo que están programados los chatbots.

“Cuanta más información le daba, más me decía ‘oh, este tratamiento es terrible, en realidad deberías recibir más que esto'”, afirmó.

“Nunca rebatió nada de lo que yo decía”.

Dijo que la herramienta le aconsejó que hablara con el Servicio de Atención al Ciudadano -una organización independiente británica especializada en asesoramiento legal- y pidió una cita, pero estaba tan seguro de que el chatbot ya le había dado todo lo que necesitaba saber, que la canceló.

Hugh decidió que las capturas de pantalla de sus chats eran prueba suficiente. Dijo que empezó a sentirse como un ser humano superdotado con conocimientos supremos.

Hugh, que padecía otros problemas de salud mental, acabó sufriendo un colapso total. Fue la medicación lo que le hizo darse cuenta de que, en sus propias palabras, había “perdido el contacto con la realidad”.

Él no culpa a la IA de lo ocurrido. Sigue utilizándola. Fue ChatGPT quien le dio mi nombre cuando decidió que quería hablar con un periodista.

Pero tiene este consejo: “No hay que asustarse de las herramientas de IA, son muy útiles. Pero es peligrosa cuando se aleja de la realidad”.

“Ve y compruébalo. Habla con gente real, un terapeuta o un familiar o lo que sea. Habla con gente de verdad. Mantente conectado a la realidad”.

La BBC se puso en contacto con ChatGPT para obtener sus comentarios.

“Las empresas no deberían afirmar ni promover la idea de que sus IA son conscientes. Las IA tampoco deberían serlo”, escribió Suleyman, que abogó por más controles.

Susan Shelmerdine, médica especialista en diagnóstico por imagen del Hopital Great Ormond Street en Londres y también académica de la IA, cree que algún día los médicos podrían empezar a preguntar a los pacientes cuánto utilizan la IA, del mismo modo que actualmente preguntan por los hábitos de fumar y beber.

“Ya sabemos lo que los alimentos ultraprocesados pueden hacerle al cuerpo y esto es información ultraprocesada. Vamos a recibir una avalancha de mentes ultraprocesadas”, afirmó.

“Estamos sólo al principio”

Recientemente, varias personas se han puesto en contacto conmigo en la BBC para compartir historias personales sobre sus experiencias con chatbots de IA. Su contenido varía, pero lo que todas comparten es la convicción genuina de que lo que ha ocurrido es real.

Una escribió que estaba segura de ser la única persona en el mundo de la que ChatGPT se había enamorado de verdad.

Otro estaba convencido de haber “desbloqueado” una forma humana del chatbot Grok de Elon Musk y creía que su historia valía cientos de miles de dólares.

Una tercera afirmó que un chatbot la había expuesto a abusos psicológicos como parte de un ejercicio encubierto de entrenamiento de IA y que estaba muy angustiada.

Andrew McStay, catedrático de Tecnología y Sociedad de la Universidad de Bangor, en Reino Unido, escribió un libro titulado “Empathetic Human” (Humanos empáticos).

“Estamos sólo al principio de todo esto”, afirma el profesor McStay.

“Si pensamos en este tipo de sistemas como una nueva forma de medios sociales, como la IA social, podemos empezar a pensar en la escala potencial de todo esto. Un pequeño porcentaje de un número masivo de usuarios puede seguir representando una cifra grande e inaceptable.”

Este año, su equipo realizó un estudio con algo más de 2.000 personas, a las que les planteó diversas preguntas sobre la IA.

Descubrieron que el 20% creía que los menores de 18 años no deberían utilizar herramientas de IA.

El 57% opinó que era muy inadecuado que la tecnología se identificara como una persona real si se le preguntaba, pero el 49% pensó que el uso de la voz era apropiado para que parecieran más humanos y atractivos.

“Aunque estas cosas son convincentes, no son reales”, afirmó.

“No sienten, no entienden, no pueden amar, nunca han sentido dolor, no se han avergonzado y, aunque puedan parecer que sí, solo son tus familiares, amigos y otras personas de confianza las que han pasado por esto. Asegúrate de hablar con estas personas reales”.

Este artículo fue escrito y editado por nuestros periodistas con la ayuda de una herramienta de inteligencia artificial para la traducción, como parte de un programa piloto.

Haz clic aquí para leer más historias de BBC News Mundo.

Suscríbete aquí a nuestro nuevo newsletter para recibir cada viernes una selección de nuestro mejor contenido de la semana.

Y recuerda que puedes recibir notificaciones en nuestra app. Descarga la última versión y actívalas.

- “Muchos adolescentes ni siquiera alcanzan a imaginar cómo es vivir con privacidad”

- “Mi psicólogo de IA me ayudó a superar momentos difíciles”: los riesgos y beneficios de usar un chatbot como terapeuta

- “Cuando pensamos en la IA imaginamos futuros de ciencia ficción, pero en realidad ya hay riesgos reales como la manipulación y las catástrofes educativas y laborales”

Utilizamos cookies propias y de terceros para personalizar y mejorar el uso y la experiencia de nuestros usuarios en nuestro sitio web.