Vacuna Patria aún no está disponible en centros de salud, pese a que Sheinbaum anunció que se aplica en campaña invernal

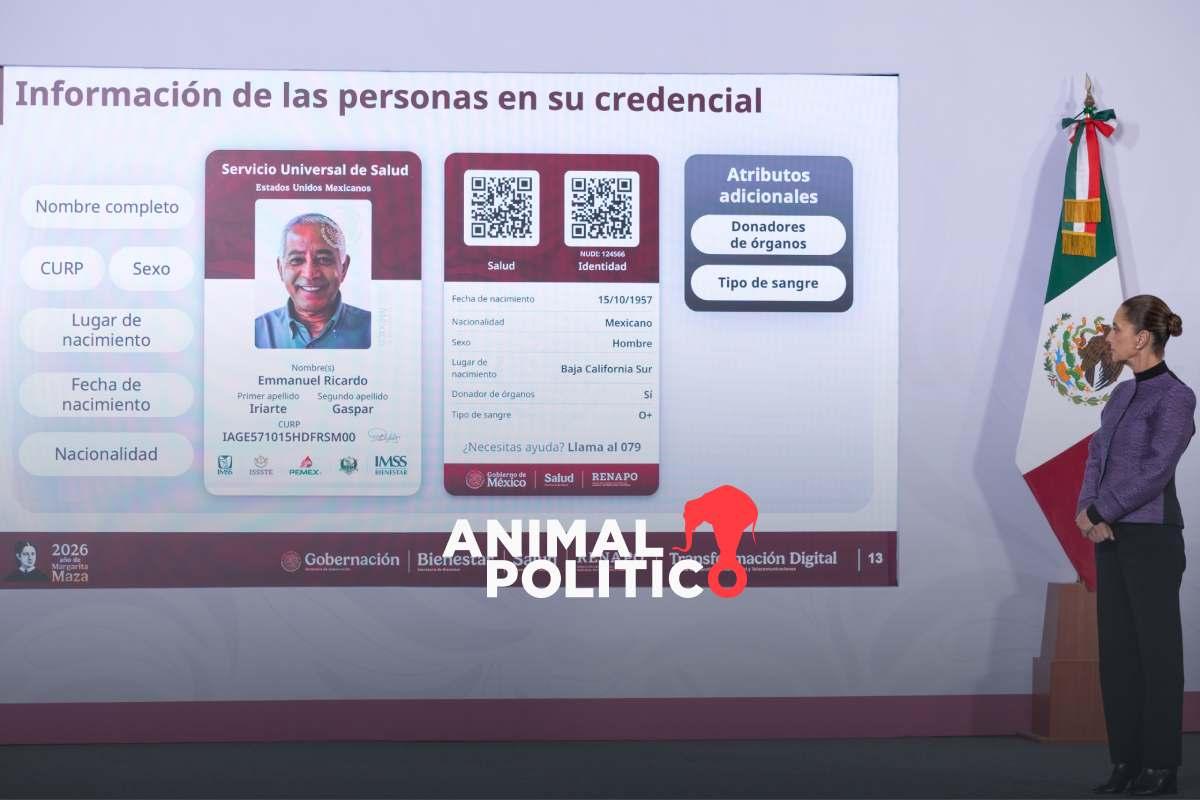

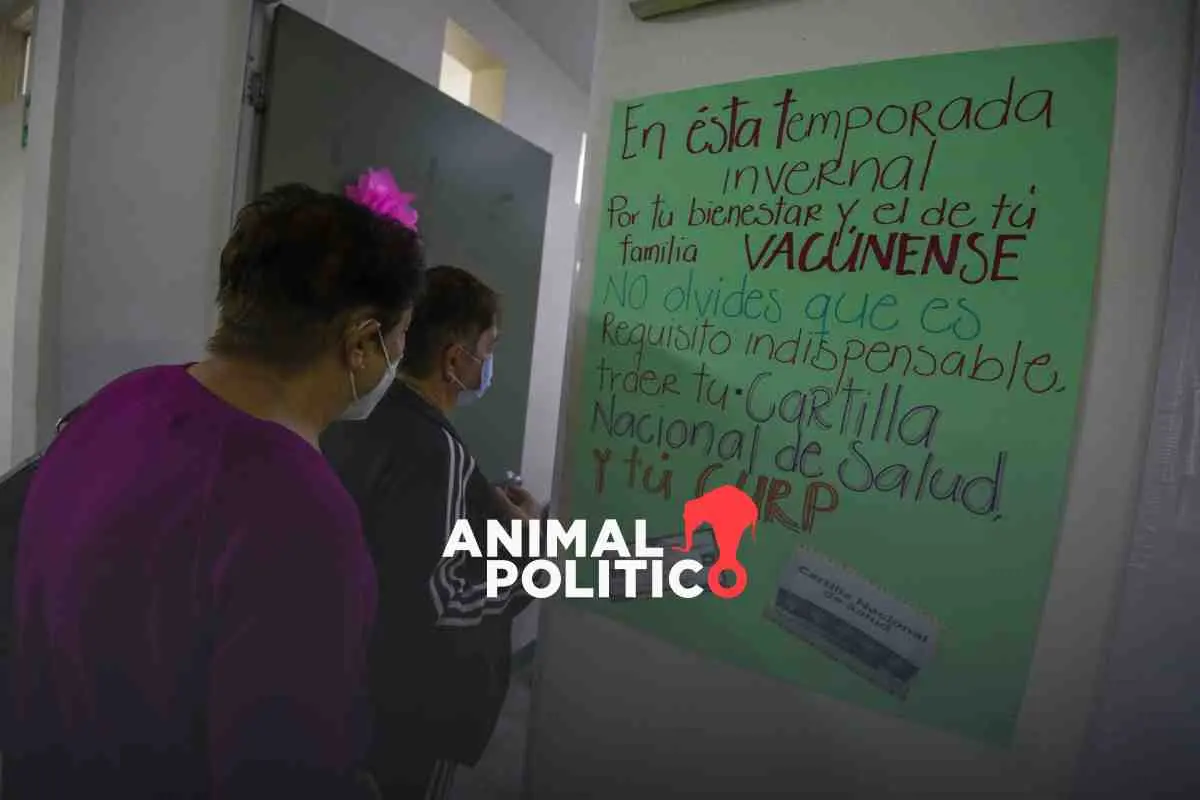

Pese a que la presidenta Claudia Sheinbaum aseguró que alrededor de 700 mil vacunas Patria son utilizadas en la campaña invernal de vacunación, el biológico todavía no concluye el proceso necesario para su distribución y aún no está disponible en los hospitales y centros de salud del país.

Cuatro años después de que empezó a ser desarrollada en México para combatir el Covid-19, la Secretaría de Salud (Ssa) reconoce que estos biológicos todavía no están disponibles.

“En este periodo se están utilizando, porque es el periodo de diciembre-enero-febrero”, respondió Sheinbaum en su conferencia matutina al ser cuestionada sobre cuándo se comenzaría a aplicar la vacuna Patria en México, tras cuatro años en los que el gobierno postergó su utilización.

Secretaría de Salud dice que vacuna Patria aún no está disponible en centros de vacunación

Luego de la declaración de Claudia Sheinbaum, Animal Político buscó a la Ssa para conocer los estados de la República y los centros de salud donde las 700 mil dosis se estarían aplicando en la actual campaña de vacunación, que va de diciembre de 2024 a febrero de 2025. La dependencia informó que la vacuna sí está contemplada en el esquema nacional, aunque aún no está disponible en los centros de vacunación.

“La vacuna Patria sí está considerada para su aplicación en el esquema nacional; sin embargo, en este momento aún no está disponible en los centros de vacunación”, señaló la dependencia por medio de su área de atención a medios de comunicación.

La Ssa agregó que “en cuanto concluya el proceso necesario para su distribución, se informará oportunamente a la población sobre su disponibilidad”.

Animal Político pidió al equipo de comunicación social de la presidenta Sheinbaum una aclaración sobre sus dichos, pero hasta el cierre de la edición no hubo ninguna respuesta.

Desde el 15 de octubre de este año, la presidenta Claudia Sheinbaum aseguró en conferencia de prensa que la vacuna Patria sería utilizada en el actual periodo invernal.

Semanas después, el 6 de noviembre, Rosaura Ruiz, secretaria Ciencia, Humanidades y Tecnología, consideró que la vacuna Patria todavía no estaría lista para ser aplicada en 2024, una declaración que se sumó a las contradicciones en las que el gobierno ha incurrido cuando se refiere a la fecha en la que estará listo el biológico.

Vacuna Patria: una promesa que no se ha cumplido

El desarrollo de la vacuna Patria comenzó en 2020 por el laboratorio mexicano Avimex, con colaboración del antiguo Consejo Nacional de Ciencia y Tecnología (Conacyt) y otros organismos públicos, como la Universidad Nacional Autónoma de México (UNAM) y el Instituto Politécnico Nacional (IPN).

La vacuna Patria fue presentada por el gobierno mexicano como un esfuerzo para regresar a la vanguardia en la fabricación de estos insumos médicos, pues desde 1999 nuestro país se había rezagado en esta área.

Pese a las buenas intenciones, y luego de cuatro años del inicio de la pandemia de Covid-19, la vacuna elaborada por Avimex sigue sin ser aplicada. De hecho su utilización se ha postergado una y otra vez.

En un primer momento el expresidente Andrés Manuel López Obrador informó que la vacuna Patria podría ser utilizada en 2022. Después el propio Conacyt calculó que las dosis estarían listas en 2023, un dato que fue respaldado por el expresidente.

A principios de este 2024, López Obrador insistió que la vacuna Patria ya estaba terminada y podría ser utilizada en los siguientes meses, pero está por terminar el año y sigue sin estar disponible en los centros de salud del país.

Ya en el nuevo gobierno, la presidenta Claudia Sheinbaum también insistió que las dosis estarían listas para aplicarse este mismo año, una promesa que hasta ahora no parece estar cerca de cumplirse.

La vacuna Patria costó al gobierno mexicano al menos 457 millones 804 mil pesos que fueron aportados por el antiguo Conacyt, según información que esa misma dependencia proporcionó a un ciudadano en la Plataforma Nacional de Transparencia, a través de la solicitud de información 330010924000780.

Este lunes 30 de diciembre, la presidenta Sheinbaum también informó que ya no se destinaron más recursos para la fabricación de la vacuna Patria, pues los niveles de contagio de Covid-19 han disminuido y ya no se requieren tantas dosis.

Nuevo gobierno mantiene dichos engañosos

Claudia Sheinbaum, que está por cumplir cuatro meses como presidenta de México, mantuvo la costumbre de hacer conferencias de prensa matutinas a diario, tal como lo hizo en sus seis años de gobierno López Obrador.

Aunque sus ruedas de prensa son más cortas y sobrias, la presidenta sigue la tendencia de presentar información engañosa, como esta vez ocurrió con su aseveración de que la vacuna Patria ya se está aplicando en la temporada de vacunación invernal.

Según Claudia Sheinbaum, este insumo médico se aplicará principalmente a personas con comorbilidades y adultos mayores.

Hasta el pasado 6 de diciembre, El Sabueso de Animal Político verificó 16 frases en las que Sheinbaum, u otros funcionarios de su gobierno, usaron datos engañosos y falsos.

En las conferencias de prensa matutinas, la presidenta y su equipo de trabajo han dicho información engañosa sobre temas de seguridad, migración, Poder Judicial o el Proyecto de Presupuesto de Egresos de la Federación 2025.

Relacionado

El presidente de EU, Donald Trump, dijo que ya no se siente obligado a pensar solo en la paz tras no haber recibido el Premio Nobel de la Paz.

Al tiempo que repitió su deseo de hacerse del control de Groenlandia, el presidente de Estados Unidos, Donald Trump, dijo que ya no se siente obligado a pensar únicamente en la paz tras no haber recibido el Premio Nobel de la Paz.

En un mensaje dirigido al primer ministro de Noruega, Jonas Gahr Støre, Trump culpó al país por no otorgarle el galardón.

“Teniendo en cuenta que su país decidió no concederme el Premio Nobel de la Paz por haber detenido ocho guerras y MÁS, ya no siento la obligación de pensar únicamente en la paz, aunque siempre será lo preponderante (pensar en la paz)”, señala el mensaje al que tuvieron acceso medios de comunicación estadounidenses.

“Ahora puedo pensar en lo que es bueno y adecuado para Estados Unidos de América”, añadió el mandatario.

De acuerdo con el líder republicano, “el mundo no será seguro a menos que tengamos el control completo y total de Groenlandia”.

CBS News, el socio de la BBC en Estados Unidos, confirmó el mensaje y su contenido.

Un comité, no un país

Støre informó que había recibido el mensaje el domingo en respuesta a un texto que él y el presidente de Finlandia, Alexander Stubb, le habían enviado a Trump.

El líder noruego dijo que habían expresado su oposición a la propuesta de aumentar los aranceles por la disputa sobre Groenlandia y apuntaron a la necesidad de que hubiese una desescalada de la situación.

En ese contexto, propusieron una llamada, el mismo día, en la que los tres participaran.

Støre le hizo ver que un comité independiente, no el gobierno de Noruega, otorgaba el Premio Nobel de la Paz.

Trump, quien no ha ocultado su deseo de ganar el galardón que se otorga anualmente, ha insistido cada vez más que Estados Unidos necesita tomar el control de Groenlandia por razones de seguridad nacional.

La isla ártica, poco poblada, pero rica en recursos, está muy bien situada para el funcionamiento de sistemas de alerta temprana, en caso de que se produzcan ataques con misiles.

Y también para el monitoreo de buques en la región.

El presidente estadounidense ha reiterado que quiere que su país compre Groenlandia y no ha descartado usar la fuerza militar contra un miembro de la alianza de seguridad de la OTAN para tomarla.

“Hace cientos de años”

El fin de semana, Trump dijo que impondría, desde febrero, un arancel del 10 % a productos de ocho países aliados de la OTAN, si se oponen a su propuesta de adquirir Groenlandia y amenazó con aumentar ese porcentaje a 25% en junio.

Se trataría de productos que lleguen a Estados Unidos procedentes de Dinamarca, Noruega, Suecia, Francia, Alemania, Reino Unido, Países Bajos y Finlandia.

En su mensaje a Støre, Trump señaló que Dinamarca no puede proteger Groenlandia de Rusia o China y preguntó: “¿por qué ellos tienen ‘un derecho de propiedad’? No hay documentos escritos, es solo que un barco llegó allá cientos de años atrás, pero nosotros también tuvimos barcos que llegaron allá”.

“He hecho más por la OTAN que cualquier otra persona desde su fundación, y ahora la OTAN debería hacer algo por Estados Unidos”.

El primer ministro británico, Keir Starmer, indicó el lunes que cualquier decisión sobre el estatus futuro de Groenlandia “le pertenece solamente al pueblo de Groenlandia y el Reino de Dinamarca” y dijo que el uso de aranceles contra aliados era “incorrecto”.

El ministro de Defensa danés, Troels Lund Poulsen, y la ministra de Relaciones Exteriores de Groenlandia, Vivian Motzfeldt, se reunirán el lunes con el secretario general de la OTAN, el general Mark Rutte.

La semana pasada, los gobiernos de Dinamarca y Groenlandia, junto a aliados de OTAN, decidieron incrementar la presencia y los ejercicios militares en el Ártico y en el Atlántico Norte.

Varios países europeos enviaron pequeños grupos de personal militar a Groenlandia en una llamada misión de reconocimiento.

La medalla

En su mensaje, Trump asegura que le ha puesto fin a ocho guerras desde que comenzó su segundo mandato como presidente, el año pasado.

El Premio Nobel de la Paz le fue concedido a la líder opositora venezolana María Corina Machado.

Cuando soldados estadounidenses atacaron Venezuela, capturaron y sacaron del país al presidente Nicolás Maduro, a quien Washington acusa de narcotráfico y otros crímenes, Trump no respaldó a Machado como la próxima líder del país, en cambio le mostró su apoyo a Delcy Rodríguez, la vicepresidenta de Maduro, que asumió como presidenta interina ante su ausencia.

Machado, quien ha elogiado a Trump, se reunió con el mandatario en la Casa Blanca la semana pasada y le dio su medalla del Nobel.

La Fundación Nobel dijo que el premio no podía “ni siquiera simbólicamente ser transferido”.

Haz clic aquí para leer más historias de BBC News Mundo.

Suscríbete aquí a nuestro nuevo newsletter para recibir cada viernes una selección de nuestro mejor contenido de la semana.

Y recuerda que puedes recibir notificaciones en nuestra app. Descarga la última versión y actívalas.

- Qué es la “bazuca comercial” de la UE que Francia pide activar para responder a las amenazas arancelarias de Trump por Groenlandia

- Trump anuncia aranceles para Dinamarca, Francia y otros 6 países europeos por oponerse a su plan para apoderarse de Groenlandia

- ¿Se puede regalar un premio Nobel como hizo María Corina Machado con Trump? (y la indignación que despierta en Noruega)